Data Center Innovation – wie durch Messgenauigkeit Energieeffizienz ermöglicht wird

Im folgenden Artikel beschreiben Keith Dunnavant von Munters und Anu Kätkä von Vaisala die jüngsten Trends im Rechenzentrumssektor und diskutieren die Auswirkungen von HLK-Messungen auf die Energieeffizienz. Bei steigenden Energiekosten suchen Regierungen dringend nach Möglichkeiten zur Reduzierung der Treibhausgasemissionen. Daher steht die Energieeffizienz von Rechenzentren im Mittelpunkt der internationalen Prüfung.

Beide Autoren verfügen über langjährige Erfahrung und Expertise im Energiemanagement von Rechenzentren. Munters ist ein weltweit führender Anbieter energieeffizienter und nachhaltiger Klimatisierungslösungen für unternehmenskritische Prozesse, einschließlich Rechenzentren, und Vaisala ist ein weltweit führender Anbieter von Wetter-, Umwelt- und Industriemessungen.

Energieverbrauch des Rechenzentrums

„Power Usage Effectiveness“ (PUE) als Maß

Der weltweite Strombedarf beträgt etwa 20.000 Terawattstunden; der IKT-Sektor (Informations- und Kommunikationstechnologie) verbraucht 2000 Terawattstunden und Rechenzentren etwa 200 Terawattstunden, was 1 Prozent der Gesamtmenge entspricht. Rechenzentren machen daher einen erheblichen Teil des Energieverbrauchs der meisten Länder aus. Schätzungen zufolge befinden sich weltweit über 18 Millionen Server in Rechenzentren. Neben dem eigenen Strombedarf benötigen diese IT-Geräte auch unterstützende Infrastruktur wie Kühlung, Stromverteilung, Brandbekämpfung, unterbrechungsfreie Stromversorgungen, Generatoren usw.

Um die Energieeffizienz von Rechenzentren miteinander zu vergleichen, ist es gängige Praxis, die „Power Usage Effectiveness“ (PUE; Effektivität der Leistungsnutzung) als Maß zu verwenden. Dieses Maß ist definiert als das Verhältnis der Gesamtenergie, die in einem Rechenzentrum verbraucht wird, zu der Energie, die nur von der IT verbraucht wird. Optimal wäre ein PUE-Wert von 1, was bedeuten würde, dass die gesamte Energie für die IT aufgewendet wird und die unterstützende Infrastruktur keine Energie verbraucht.

Um den PUE zu minimieren, besteht also das Ziel darin, den Verbrauch der unterstützenden Infrastruktur wie Kühlung und Stromverteilung zu reduzieren. Der typische PUE-Wert in herkömmlichen Rechenzentren liegt bei etwa 2, während große Hyperscale-Rechenzentren unter 1,2 liegen können. Der globale Durchschnitt lag 2020 bei etwa 1,67. Das bedeutet, dass durchschnittlich 40 Prozent des gesamten Energieverbrauchs Nicht-IT-Verbrauch sind. Die PUE ist jedoch ein Verhältnis, sagt also nichts über die Gesamtmenge des Energieverbrauchs aus. Die PUE sieht also immer dann gut aus, wenn die IT-Geräte im Vergleich zum Kühlsystem viel Energie verbrauchen. Daher ist es wichtig, neben der Effizienz und dem Lebenszyklus des IT-Equipments auch den Gesamtstromverbrauch zu messen. Außerdem sollte aus ökologischer Sicht berücksichtigt werden, wie der Strom erzeugt wird, wie viel Wasser verbraucht wird (sowohl bei der Stromerzeugung als auch am Standort zur Kühlung) und, ob Abwärme genutzt wird.

Das PUE-Konzept wurde ursprünglich 2006 von Green Grid entwickelt und 2016 als ISO-Standard veröffentlicht. Wir arbeiten weltweit an der Energie- und Ressourceneffizienz der Ökosysteme in Rechenzentren und streben danach, die CO2-Emissionen zu minimieren.

PUE bleibt die gebräuchlichste Methode zur Berechnung der Energieeffizienz von Rechenzentren. Bei Munters beispielsweise wird der PUE für jedes Projekt sowohl auf Spitzen- als auch auf Jahresbasis bewertet. Bei der Berechnung der PUE-Metriken werden nur die IT-Last und die Kühllast für die PUE-Berechnung berücksichtigt. Dies wird entweder als partielle PUE (pPUE) oder mechanische PUE (PUEM) bezeichnet. Der pPUE-Spitzenwert wird von Elektroingenieuren verwendet, um die maximalen Lasten festzulegen und Ersatzgeneratoren zu dimensionieren. Der annualisierte pPUE wird verwendet, um zu bewerten und mit anderen Kühloptionen zu vergleichen, wie viel Strom während eines typischen Jahres verbraucht wird. Auch wenn PUE kein perfektes Instrument ist, wird es zunehmend durch andere Maßnahmen wie WUE (Water Usage Effectiveness), CUE (Carbon Usage Effectiveness) sowie Ansätze unterstützt, die die Relevanz der PUE erhöhen können, einschließlich SPUE (Server PUE) und TUE (Total PUE).

Trends bei Rechenzentren

In den letzten zehn Jahren haben effiziente Hyperscale-Rechenzentren ihren relativen Anteil am Gesamtenergieverbrauch von Rechenzentren erhöht, während viele der weniger effizienten traditionellen Rechenzentren geschlossen wurden. In der Folge ist der Gesamtenergieverbrauch noch nicht dramatisch gestiegen. Diese neu gebauten Hyperscale-Rechenzentren wurden auf Effizienz ausgelegt. Wir wissen jedoch, dass es aufgrund vieler aufkommender Trends wie KI, maschinellem Lernen, Automatisierung, fahrerlosen Fahrzeugen usw. eine wachsende Nachfrage nach Informationsdiensten und rechenintensiven Anwendungen geben wird. Der Energiebedarf von Rechenzentren wird daher voraussichtlich steigen, und das Ausmaß des Anstiegs ist Gegenstand von Diskussionen. Bis 2030 wird sich der weltweite Energieverbrauch von Rechenzentren im Best-Case-Szenario im Vergleich zur aktuellen Nachfrage verdreifachen, als wahrscheinlicher wird jedoch ein Anstieg um das Achtfache angenommen. Diese Energieverbrauchsprognosen umfassen sowohl IT- als auch Nicht-IT-Infrastruktur. Der Großteil des Nicht-IT-Energieverbrauchs entfällt auf die Kühlung, oder genauer gesagt, auf die Ableitung der Wärme von den Servern, und die Kühlungskosten allein können leicht bis zu 25 Prozent oder mehr der jährlichen Gesamtenergiekosten ausmachen. Kühlung ist natürlich eine Notwendigkeit für die Aufrechterhaltung der IT-Funktionalität, und dies kann durch gutes Design und durch den effektiven Betrieb von Gebäudesystemen optimiert werden.

Ein wichtiger aktueller Trend ist eine Erhöhung der Leistungsdichte von Server-Racks, von denen einige 30 bis 40 Kilowatt oder noch mehr benötigen. Laut einer von AFCOM, dem Branchenverband für Rechenzentrumsfachleute, durchgeführten Untersuchung ergab der Bericht „2020 State of the Data Center“, dass die durchschnittliche Rack-Dichte auf 8,2 kW pro Rack gestiegen ist; gegenüber 7,3 kW im Jahr 2019 und 7,2 kW im Jahr 2018. Etwa 68 Prozent der Befragten gaben an, dass die Rack-Dichte in den letzten drei Jahren zugenommen hat.

Die Verlagerung hin zum Cloud Computing fördert sicherlich die Entwicklung von Hyperscale- und Co-Location-Rechenzentren. Früher wäre ein 1-Megawatt-Rechenzentrum darauf ausgelegt gewesen, die Anforderungen einer Bank, einer Fluggesellschaft oder einer Universität zu erfüllen, aber viele dieser Institutionen und Unternehmen stellen jetzt auf Cloud-Dienste innerhalb von Hyperscale- und Co-Location-Rechenzentrumseinrichtungen um. Als Folge dieser wachsenden Nachfrage besteht ein erhöhter Bedarf an Datengeschwindigkeit, und natürlich bedienen alle diese Rechenzentren auch unternehmenskritische Anwendungen, sodass die Zuverlässigkeit der Infrastruktur sehr wichtig ist.

Es gibt auch einen verstärkten Fokus auf Edge-Rechenzentren, um die Latenz (Verzögerung) zu reduzieren, sowie auf die Einführung von Flüssigkeitskühlung, um Hochleistungschips aufzunehmen und den Energieverbrauch zu reduzieren.

Steuerung von Temperatur und Feuchte

Eine der wichtigsten Überlegungen zur Energieeffizienz bei der Luftkühlung eines Rechenzentrums ist die Einhausung von Warmgängen/Kaltgängen. Leider werden Dämmung und Einhausung in vielen bestehenden Rechenzentren immer noch zu wenig beachtet, was zu einer geringen Energieeffizienz führt. Bei Neubauten von Rechenzentren wird die Einhausung hingegen immer mehr sehr ernst genommen, was erheblich zur Performance beiträgt.

Bei Vielen liegen die Zulufttemperaturen im Optimalfall zwischen 24 °C und 25,5 °C (75,2 °F und 77,9 °F). Das Delta-T ist jedoch sehr wichtig – die Temperaturdifferenz zwischen dem warmen Gang und dem kalten Gang. Normalerweise liegt das Delta-T bei etwa 10 bis 12 °C (18 bis 21,6 °F), ein übliches Ziel beim Design von Rechenzentren ist jedoch 14 °C (25.2 °F). Das Erhöhen des Delta-T führt zu einem doppelten Vorteil, indem es den Energieverbrauch des Lüftermotors reduziert, der von den Kühlsystemen benötigt wird, und das strategische Potenzial für die Einsparung bei der Wärmeabfuhr erhöht.

Ökonomisierung ist der Prozess, bei dem Außenluft genutzt werden kann, um einen Teil der Wärmeabfuhr des Rechenzentrums zu erleichtern. Die Ökonomisierung kann direkt erfolgen, indem einfach die Außenluft in die Kühlsysteme eingebracht und (nach entsprechender Luftfilterung) zu den Servern geleitet wird, oder indirekt, indem die Umluft des Rechenzentrums über einen Luft-Luft-Wärmetauscher an die Umgebung abgegeben wird. Das senkt die Kosten und verbessert die Effizienz und Nachhaltigkeit. Um jedoch die Effizienz aufrechtzuerhalten, sollten luftseitige Druckabfälle aufgrund der Filtration minimiert werden. Wenn also die Luft innerhalb des Rechenzentrums ohne Zufuhr von Außenluft umgewälzt wird, sollte es möglich sein, die Notwendigkeit der Filterung zu reduzieren oder ganz zu beseitigen.

Kühlung und Belüftung erfordern eine sorgfältige Steuerung, und es ist wichtig, hocheffiziente Ventilatoren einzusetzen, einen leichten Überdruck im Gebäude aufrechtzuerhalten und die Raumfeuchte zu kontrollieren. Zum Beispiel sollten Frischluftsysteme den Taupunkt im Raum so niedrig halten, dass Kühlschlangen nur eine leichte Kühlung übernehmen, ohne eine latente Last (Entfernung des Feuchtigkeitsgehalts der Luft) angehen zu müssen.

Das übergeordnete Ziel des Wärmeabfuhrsystems besteht darin, optimale Bedingungen für die IT-Ausrüstung aufrechtzuerhalten und gleichzeitig den Energieverbrauch zu minimieren. Niedrige Luftfeuchte kann beispielsweise das Risiko statischer Elektrizität erhöhen, und hohe Luftfeuchte kann Kondensation verursachen, eine Gefahr für elektrische Geräte und metallene Ausrüstung. Das Resultat ist eine Erhöhung des Ausfallrisikos und eine Verkürzung der Lebensdauer. Es hat sich gezeigt, dass eine hohe Luftfeuchte in Kombination mit verschiedenen Umweltschadstoffen die Korrosion verschiedener Komponenten in Servern beschleunigt.

Kühlung ist wesentlich, um die von IT-Geräten erzeugte Wärme abzuführen, damit Überhitzung und Ausfälle vermieden werden. Einigen Studien zufolge kann eine schnell schwankende Temperatur tatsächlich schädlicher für die IT-Geräte sein als eine stabil höhere Temperatur, daher ist der Regelkreis aus dieser Perspektive wichtig.

Die neuesten IT-Geräte können typischerweise bei höheren Temperaturen betrieben werden, was bedeutet, dass die Zufuhrtemperatur angehoben werden kann und das Potenzial für freie Kühlung und Einsparung verbessert wird. Außenluft kann verwendet werden, um Innenluft entweder direkt oder indirekt (wie oben erwähnt) zu kühlen, und eine Verdunstungs- oder adiabatische Kühlung kann die Effizienz der Ökonomisierung weiter verbessern. Diese energiesparenden Technologien wurden umfassend eingesetzt, wobei der Trend zu trockenen Wärmeabfuhrstrategien geht, bei denen kein Wasser verbraucht wird. Mit steigender Temperatur des Mediums für die Wärmeentnahme (Luft oder Flüssigkeit) steigt das Potenzial für eine effektive Nutzung der Abwärme von Rechenzentren, die beispielsweise die Nutzung in Fernwärmenetzen ermöglicht. In Helsinki arbeiten beispielsweise Microsoft und der Energiekonzern Fortum an einem Projekt zur Abwärmenutzung. Das Rechenzentrum wird zu 100 Prozent emissionsfreien Strom nutzen, und Fortum wird die saubere Wärme aus dem Serverkühlungsprozess an Wohnungen, Dienstleistungs- und Geschäftsräume übertragen, die an sein Fernwärmesystem angeschlossen sind. Diese Anlage für die Abwärmenutzung von Rechenzentren ist wahrscheinlich die größte ihrer Art weltweit.

Die Bedeutung genauer Überwachung

In vielen modernen Einrichtungen wird eine Verfügbarkeit von 99,999 % erwartet, was einer jährlichen Ausfallzeit von nur wenigen Minuten entspricht. Diese extrem hohen Leistungsniveaus sind aufgrund der Bedeutung und des Werts der Daten und Prozesse erforderlich, die von der IT-Infrastruktur verarbeitet werden.

Ein Schlüsselmerkmal beim Design von Rechenzentren ist die Bereitstellung der richtigen Temperatur für die Server, und dies kann nur erreicht werden, wenn sich das Steuerungssystem auf genaue Sensoren verlassen kann. Größere Datenräume können schwieriger zu überwachen sein, da sie ein größeres Potenzial für räumliche Temperaturschwankungen aufweisen. Daher ist es wichtig, dass eine ausreichende Anzahl von Temperatursensoren vorhanden ist, um sicherzustellen, dass alle Server überwacht werden.

Einige Server befinden sich möglicherweise in der Nähe einer Kühleinheit, andere weiter entfernt. Einige befinden sich möglicherweise ganz unten in einem Rack, andere weiter oben, sodass ein Potenzial für Veränderungen in allen drei Dimensionen besteht. Neben einer ausreichenden Anzahl an Sensoren ist es daher auch wichtig, dass Luftstrom und Kühlung optimal im Serverraum verteilt sind. Durch eine Kombination aus richtigem Design und Überwachung ist es möglich, Kühlung und Luftstrom effizient zu steuern, um die erforderlichen Spezifikationen zu erfüllen.

Um die Auswirkungen verschiedener Variablen auf den durchschnittlichen jährlichen Energieverbrauch zu bewerten, hat Munters sein System modelliert, das mit drei verschiedenen Steuerungssystemen an drei verschiedenen Standorten betrieben wird, jeweils mit einem Rechenzentrum für 1 Megawatt ITE-Last:

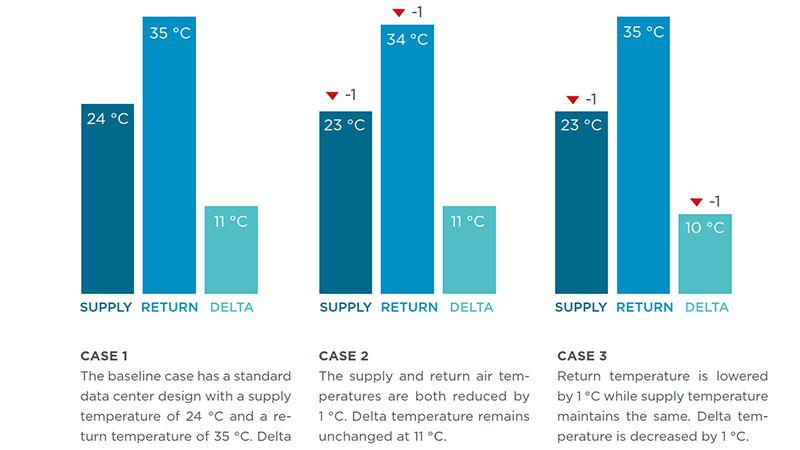

- Das Basisszenario ist ausgelegt auf eine Zufuhrtemperatur von 24 °C (75,2 °F) und eine Rücklauftemperatur von 35 °C (95 °F) (Delta-T = 11 °C, 19,8 °F).

- Im zweiten Fall wurden die Zufuhr- und Rücklauftemperaturen um 1 °C bzw. 1,8 °F abgesenkt (bei gleichem Delta-T).

- Im dritten Fall wurde lediglich die Rücklauftemperatur um 1 °C bzw. 1.8 °F abgesenkt (und der Delta-T verringert).

Die Ergebnisse zeigten in allen drei Szenarien einen geringeren Energieverbrauch am Standort mit milderem Klima. Szenario 2 zeigte 1 bis 2 Prozent zusätzlichen Energieverbrauch durch Absenken der Zuluft- und Rücklauftemperaturen um nur ein Grad. Szenario 3 zeigte den deutlichsten Anstieg des Energieverbrauchs; Durch die Senkung der Rücklauftemperatur um nur 1 °C (und damit des Delta-T) stieg der Energieverbrauch an allen drei Standorten um 8 bis 9 %. Diese große Auswirkung einer kleinen Temperaturabweichung unterstreicht die Bedeutung von Delta-T und Sensorgenauigkeit.

Welche Kühlmethoden auch immer eingesetzt werden, ist es von entscheidender Bedeutung, HLK-Prozesse und Innenraumbedingungen zuverlässig zu steuern. Um dies zu erreichen, müssen sich Rechenzentrumsmanager auf kontinuierlich genaue Messungen verlassen können, denn der Regelkreis kann nur so gut sein wie die Messungen. Aus diesem Grund ermöglichen hochwertige Sensoren effizient gesteuerte HLK-Prozesse und ein stabiles Raumklima. Die Sensorspezifikation zum Zeitpunkt der Installation ist jedoch nicht unbedingt ein Indikator für die langfristige Leistungszuverlässigkeit. Der wahre Wert eines Sensors wird über seinen gesamten Lebenszyklus abgeleitet, da häufige Wartungsanforderungen kostspielig sein können, und wie in den Munters-Modellen skizziert, können selbst kleine Genauigkeitsabweichungen zu überhöhten Energiekosten führen.

In den meisten Fällen ist der Wert der Daten in der IT-Infrastruktur extrem hoch und oft geschäftskritisch, sodass es keinen Sinn macht, kostengünstige Sensoren einzusetzen, wenn dies zu hohen Wartungskosten oder Risiken für hochwertige Daten führt. Anwender sollten sich daher nach langlebigen Messgeräten umsehen, die langfristig zuverlässige und stabile Messwerte liefern können, denn auf diese lebenslange Zuverlässigkeit kommt es an.

Messtechnik für anspruchsvolle Umgebungen

Der Fokus auf Genauigkeit, Zuverlässigkeit und Stabilität von Messgeräten ist seit seiner Gründung vor über 86 Jahren ein wichtiger Markenwert für Vaisala. Diese Merkmale sind daher grundlegende Bestandteile des Designauftrags für jedes Vaisala-Produkt. Vaisala-Sensoren demonstrieren die Vorteile dieser Funktionen seit über acht Jahren auf dem Planeten Mars und liefern problemlos Daten unter rauen Bedingungen an Bord des NASA-Rover Curiosity und seit kurzem auch auf dem Rover Perseverance.

Rechenzentren stellen eine weniger herausfordernde Umgebung als der Weltraum dar, aber zuverlässige Sensoren sind angesichts des wesentlichen Dienstes, den Rechenzentren für Unternehmen, Volkswirtschaften und Gesellschaften weltweit erbringen, ebenso wichtig.

Faktoren, die die Wahl der Sensoren beeinflussen

1. Zuverlässigkeit

Die Genauigkeit des Sensors am Installationsort ist natürlich wichtig, es ist jedoch entscheidend, dass der Sensor langfristig genau bleibt und stabile Messwerte liefert. Angesichts des hohen Wertes von Rechenzentren und ihrer häufig abgelegenen Lage sollte die Lebensdauer der Sender weit über der Norm liegen. Der Hersteller sollte daher über Erfahrung in der Branche verfügen, gepaart mit einem guten Ruf für zuverlässige Messungen in kritischen Umgebungen. Rückführbare Kalibrierzertifikate bieten die Gewissheit, dass die Sensoren vor Verlassen des Werks korrekt funktionierten, und die nachgewiesene Zuverlässigkeit bedeutet, dass dieses Genauigkeitsniveau langfristig aufrechterhalten werden kann.

2. Wartung

Sensoren mit hohem Wartungsbedarf sollten vermieden werden; nicht nur wegen der damit verbundenen Kosten, sondern auch, weil solche Sensoren ein höheres Ausfallrisiko bergen. Darüber hinaus können driftende oder an Genauigkeit verlierende Sensoren, wie oben erläutert, enorme Energiekosten verursachen. Die hohe Verfügbarkeit von Rechenzentren setzt voraus, dass Wartungsarbeiten an Überwachungsgeräten den Betrieb des Rechenzentrums nicht stören sollten. Folglich sind Instrumente wie die von Vaisala mit austauschbaren Messsonden oder ‑modulen vorteilhaft; nicht zuletzt, weil sie es ermöglichen, Sensoren zu entfernen und offline zu kalibrieren. Wichtig ist es, beim Austausch einer Messsonde oder eines Moduls auch das Kalibrierzertifikat zu aktualisieren. Idealerweise sollte es möglich sein, Wartungsarbeiten vor Ort mit Werkzeugen des Instrumentenanbieters durchzuführen, und diese Arbeiten sollten im Rahmen eines planmäßigen Wartungsprogramms durchgeführt werden.

3. Nachhaltigkeit

Aus der Sensorperspektive ermöglichen die neuesten Technologien den Benutzern, nur den Messteil eines Sensors aufzurüsten, anstatt den gesamten Messwertgeber austauschen oder entsorgen zu müssen. Dadurch helfen sie, unnötigen Abfall zu vermeiden. Die Referenzen der Lieferanten in Bezug auf Umwelt und Nachhaltigkeit sollten bei Kaufentscheidungen berücksichtigt werden. Dadurch wird Nachhaltigkeit entlang der Lieferketten weitergereicht und schafft Motivation für alle Unternehmen, ob groß oder klein. Nachhaltigkeit steht sowohl bei Munters als auch bei Vaisala im Mittelpunkt. Munters hat beispielsweise weltweit mehr als 1,5 Gigawatt an Kühlgeräten für Rechenzentren installiert und damit Energieeinsparungen erzielt, die zwei Prozent des jährlichen Energieverbrauchs Schwedens entsprechen. Vaisala wurde kürzlich von der Financial Times in die Top-5-Liste der European Climate Leaders 2022 aufgenommen. Die Liste enthält die europäischen Unternehmen, die zwischen 2015 und 2020 die größte Reduzierung ihrer Treibhausgasemissionen erreicht haben.

Zusammenfassung

Da kritische Daten im Wert von Milliarden von Dollar in Rechenzentren verarbeitet und gespeichert werden, müssen leistungshungrige Server unter idealen Temperatur- und Feuchtigkeitsbedingungen gehalten werden, um Ausfallzeiten zu vermeiden. Gleichzeitig gibt es dringende Forderungen nach geringeren Treibhausgasemissionen, verbesserter Energieeffizienz, niedrigeren Energiekosten und besseren PUE-Maßnahmen; alles in einer Zeit steigender Energiekosten. Dieser „perfekte Ansturm“ der treibenden Kräfte bedeutet, dass die genaue Steuerung und Optimierung von HLK-Prozessen äußerst wichtig ist.

Über die Autoren

Keith Dunnavant ist VP Sales bei Munters und verantwortlich für das Rechenzentrengeschäft in Amerika. Anu Kätkä ist Produktmanager bei Vaisala und verantwortlich für Vaisalas globalen Produktbereich für Rechenzentren und HLK-Technik.