Innovation dans les centres de données - comment l'exactitude des mesures assure l'efficacité énergétique

Dans l'article suivant, Keith Dunnavant de Munters et Anu Kätkä de Vaisala décrivent les tendances récentes observées dans le secteur des centres de données et discutent de l'impact des mesures CVC sur l'efficacité énergétique. Avec la montée en flèche des coûts de l'énergie et le besoin urgent des gouvernements de trouver des possibilités pour réduire les émissions de gaz à effet de serre, l'efficacité énergétique des centres de données est au centre de l'attention internationale.

Les deux auteurs ont une grande expérience et un haut niveau de compétences dans la gestion énergétique des centres de données. Au niveau international, la société Munters compte parmi les plus grands prestataires de solutions de contrôle climatique écoénergétiques et durables pour les processus critiques, y compris les centres de données. Vaisala est un leader mondial des mesures météorologiques, environnementales et industrielles.

Consommation d'énergie du centre de données

Le facteur « Indicateur d'efficacité énergétique » (PUE)

La demande mondiale d'électricité est d'environ 20 000 térawatts/heure. Le secteur des TIC (technologies de l'information et des communications) consomme 2 000 térawatts/heure et les centres de données, environ 200 térawatts/heure, soit 1 % du total. Les centres de données consomment donc une part significative de l'énergie disponible dans la plupart des pays. Le nombre de serveurs mis en place dans les centres de données du monde a été estimé à plus de 18 millions. En plus de leurs propres besoins énergétiques, ces appareils informatiques nécessitent également une infrastructure auxiliaire comme le refroidissement, la distribution électrique, le système d'extinction, les alimentations sans interruption, les générateurs, etc.

Pour comparer l'efficacité énergétique des centres de données, il est courant d'utiliser le facteur « Indicateur d'efficacité énergétique » (PUE). Il est défini comme le rapport entre l'énergie totale nécessaire à un centre de données et l'énergie consommée uniquement par le matériel informatique. Un PUE optimal est égal à 1. Autrement dit, la totalité de l'énergie est alors transmise à l'équipement informatique, avec zéro watt pour l'infrastructure auxiliaire.

Ainsi, pour minimiser le PUE, l'objectif est de réduire la consommation de l'infrastructure auxiliaire comme le refroidissement et la distribution énergétique. En général, le PUE des centres de données traditionnels hérités est d'environ 2, tandis que les grands centres de données hyperscale peuvent atteindre moins de 1,2. La moyenne mondiale était d'environ 1,67 en 2020. Ceci signifie qu'en moyenne, 40 % de la consommation totale d'énergie n'est pas due au matériel informatique. Cependant, le PUE est un facteur mathématique. Il ne nous dit rien sur la quantité totale d'énergie consommée. Autrement dit, si les appareils informatiques consomment beaucoup d'énergie par rapport au système de refroidissement, le PUE sera acceptable. Il est donc important de mesurer également la consommation électrique totale, ainsi que l'efficacité et le cycle de vie de l'équipement informatique. Par ailleurs, d'un point de vue environnemental, il faut aussi prendre en compte la source de production de l'énergie électrique, la quantité d'eau consommée (à la fois pour la production d'électricité et sur le site pour le refroidissement) et le cas échéant, l'utilisation de la chaleur résiduelle.

À l'origine, le concept PUE a été développé par le Green Grid en 2006 et publié sous forme de norme ISO en 2016. Le Green Grid est un consortium industriel ouvert d'opérateurs de centres de données, de fournisseurs de cloud, de fournisseurs de technologies et d'équipements, d'architectes d'installations et d'utilisateurs finaux travaillant à l'échelle mondiale sur l'efficacité énergétique et les ressources des écosystèmes de centres de données dans le but de réduire au minimum les émissions de carbone.

Le PUE reste la méthode préférée pour calculer l'efficacité énergétique des centres de données. Chez Munters, par exemple, le PUE est évalué à partir des pics de consommation, sur une base annualisée pour chaque projet. Lors du calcul des indicateurs PUE, seules la charge informatique et la charge de refroidissement sont prises en compte dans le calcul du PUE. On parle alors de PUE partiel (pPUE) ou de PUE mécanique (PUEM). Le pPUE crête est utilisé par les ingénieurs électriciens pour établir les charges maximales et dimensionner les générateurs de secours. Le pPUE annualisé permet d'évaluer la quantité d'électricité qui sera consommée au cours d'une année type et de la comparer à d'autres options de refroidissement. Bien que le PUE ne soit pas un outil parfait, il est de plus en plus soutenu par d'autres mesures comme le WUE (efficacité de l'utilisation de l'eau), le CUE (efficacité de l'utilisation du carbone) ainsi que par des approches qui peuvent améliorer la pertinence du PUE, y compris le SPUE (Server PUE) et le TUE (PUE total).

Tendances des centres de données

Au cours des dix dernières années, les centres de données hyperscale efficaces ont augmenté leur part relative dans la consommation totale d'énergie des centres de données, tandis que de nombreux centres de données traditionnels moins efficaces ont été fermés. Par conséquent, la consommation totale d'énergie n'a pas encore augmenté de façon spectaculaire. Ces centres de données hyperscale nouvellement construits ont été conçus de manière à optimiser l'efficacité. Cependant, nous savons qu'il y aura une demande croissante de services d'information et d'applications à forte intensité de calcul, en raison de nombreuses tendances émergentes telles que l'IA, l'apprentissage automatique, l'automatisation, les véhicules sans conducteur, etc. Par conséquent, la demande énergétique des centres de données devrait augmenter. C'est ce niveau d'augmentation qui fait l'objet de débats. Au regard de la demande actuelle et dans le meilleur des cas, la consommation mondiale d'énergie des centres de données triplera d'ici 2030. Cependant, une multiplication par huit est considérée comme plus probable. Ces projections de la consommation d'énergie incluent à la fois l'infrastructure informatique et non informatique. La majorité de la consommation d'énergie non informatique provient du refroidissement, ou plus précisément de la chaleur libérée par les serveurs, et le coût du refroidissement peut, à lui seul, facilement représenter jusqu'à 25 % ou plus des coûts énergétiques annuels totaux. Le refroidissement est bien sûr une nécessité pour maintenir la fonctionnalité informatique. Il peut être optimisé par une bonne conception et par le fonctionnement efficace des systèmes du bâtiment.

Une tendance récente importante consiste à augmenter la densité énergétique des racks de serveurs, avec des puissances de 30 à 40 kilowatts et plus. Selon une étude menée par l'AFCOM, l'association industrielle des professionnels des centres de données, le rapport de 2020 sur l'état des centres de données a révélé que la densité moyenne des racks est passée à 8,2 kW par rack, comparé à 7,3 kW en 2019 et 7,2 kW en 2018. Environ 68 % des personnes interrogées ont indiqué que la densité des racks avait augmenté au cours des trois dernières années.

La transition vers le cloud computing promeut certainement le développement des centres de données hyperscale et de colocation. Auparavant, un centre de données de 1 mégawatt aurait été conçu pour répondre aux besoins d'une banque, d'une compagnie aérienne ou d'une université, mais bon nombre de ces institutions et entreprises se tournent désormais vers les services cloud des installations équipées de centres de données hyperscale et colocalisés. En raison de cette demande croissante, la vitesse des données est devenue un enjeu central. Et bien sûr, tous ces centres de données sont dédiés à des applications critiques, la fiabilité de l'infrastructure est donc très importante.

L'accent est également mis sur les centres de données périphériques pour réduire la latence (délai), ainsi que sur le refroidissement liquide mieux adapté aux puces hautes performances et qui permet de réduire la consommation d'énergie.

Contrôle de la température et de l'humidité

L'un des principaux facteurs à prendre en compte dans le calcul de l'efficacité énergétique du refroidissement des centres de données à l'air est le confinement allée chaude/allée froide. Malheureusement, le confinement est encore mal géré dans de nombreux centres de données hérités, ce qui entraîne une faible efficacité énergétique. En revanche, les nouveaux bâtiments pour centres de données ont tendance à prendre le confinement très au sérieux, ce qui contribue de manière significative aux performances.

Pour beaucoup, les températures de soufflage sont optimales entre 24 °C et 25,5 °C (75,2 °F et 77,9 °F). Cependant, le delta-T est très important - le différentiel de température entre l'allée chaude et l'allée froide. En général, le delta-T est d'environ 10 à 12 °C (18 à 21,6 °F), mais 14 °C (25,2 °F) est un objectif fréquent dans la conception de centres de données. L'augmentation du delta-T présente le double avantage : réduire la consommation d'énergie du moteur du ventilateur requise par les systèmes de refroidissement et augmenter le potentiel d'économie des stratégies de rejet de chaleur.

L'économisation est le processus par lequel l'air extérieur peut être utilisé pour améliorer en partie le rejet de chaleur du centre de données. L'économisation peut avoir lieu directement en introduisant volontairement de l'air extérieur dans les systèmes de refroidissement et en le mettant en contact avec les serveurs (après une filtration appropriée) ou indirectement par recirculation, en combinant l'air rejeté par le centre de données à l'air ambiant au moyen d'un échangeur de chaleur air-air. Cela réduit les coûts et améliore l'efficacité et la durabilité. Cependant, pour maintenir l'efficacité, les baisses de pression côté air dues à la filtration, doivent être minimisées. Ainsi, si l'air est recirculé dans le centre de données sans introduire d'air extérieur, il devrait être possible de réduire ou d'éliminer complètement le besoin de filtration.

Le refroidissement et la ventilation nécessitent un contrôle minutieux. Il est donc important d'utiliser des ventilateurs performants, de maintenir une légère pression positive dans le bâtiment et de contrôler l'humidité de la pièce. Par exemple, les systèmes d'air d'appoint doivent maintenir le point de rosée de l'espace à un niveau suffisamment bas pour que les serpentins de refroidissement n'effectuent qu'un léger refroidissement, sans devoir faire face à une charge latente (élimination de l'humidité de l'air).

L'objectif global du système de rejet de chaleur est de maintenir des conditions optimales pour l'équipement informatique, tout en minimisant la consommation d'énergie. Ainsi, une faible humidité peut augmenter le risque d'électricité statique et une humidité élevée peut entraîner la formation de condensation, ce qui constitue une menace pour les équipements électriques et métalliques, augmentant le risque de panne et réduisant la durée de vie. Il a été démontré que des niveaux d'humidité élevés, combinés à différents polluants ambiants accélèrent la corrosion de plusieurs composants des serveurs.

Le refroidissement et la climatisation sont nécessaires pour évacuer la chaleur générée par le matériel informatique afin d'éviter la surchauffe et d'empêcher les pannes. Selon certaines études, les fluctuations rapides de la température peuvent être plus dangereuses pour les appareils informatiques qu'une température plus élevée, mais constante. À cet égard, la boucle de régulation joue donc un rôle important.

En général, le matériel informatique de la dernière génération est capable de fonctionner à des températures plus élevées. Autrement dit, la température d'entrée peut augmenter et le potentiel de refroidissement naturel et d'économisation est amélioré. L'air extérieur peut servir à refroidir l'air intérieur soit directement, soit indirectement (comme sus-mentionné). Par ailleurs, le refroidissement évaporatif ou adiabatique peut également améliorer l'efficience de l'optimisation. Ces technologies écoénergétiques ont été déployées à grande échelle, la tendance allant vers les stratégies de rejet de la chaleur sèche qui ne consomment pas d'eau. Quand la température du fluide d'extraction de la chaleur (air ou liquide) augmente, le potentiel d'utilisation efficace de la chaleur résiduelle des centres de données augmente, ce qui permet par exemple de l'utiliser dans les réseau de chauffage urbain. À Helsinki par exemple, Microsoft et le groupe énergétique Fortum travaillent en commun sur un projet de récupération de la chaleur résiduelle. Le centre de données utilisera 100 pour cent de l'électricité à émission zéro et Fortum transférera la chaleur propre libérée lors du processus de refroidissement du service aux logements, services et locaux commerciaux connectés à son système de chauffage urbain. L'installation de recyclage de la chaleur résiduelle du centre de données sera probablement la plus grande du genre au monde.

L’importance de la surveillance exacte

Dans de nombreuses installations modernes, une disponibilité de 99,999 % est attendue, ce qui représente un temps d'arrêt annuel de quelques minutes seulement. Ces niveaux de performances extrêmement élevés sont nécessaires en raison de l'importance et de la valeur des données et des processus gérés par l'infrastructure informatique.

La mise à disposition de la température correcte aux serveurs est une caractéristique clé des conceptions de centres de données. Elle ne peut être garantie que si le système de surveillance est équipé de capteurs exacts. Les salles de données plus grandes peuvent être plus difficiles à surveiller car elles ont un plus grand potentiel de variabilité spatiale de la température. Il est donc important qu'il y ait un nombre suffisant de capteurs de température pour garantir la surveillance de tous les serveurs.

Certains serveurs peuvent être proches d'une unité de refroidissement et d'autres peuvent être plus éloignés ; certains peuvent être au bas d'une baie, et d'autres plus haut, il existe donc un potentiel de variabilité tridimensionnelle. En plus d'un nombre suffisant de capteurs, il est donc également important que le flux d'air et le refroidissement soient répartis de manière optimale dans toute la salle des serveurs. En associant une conception et une surveillance appropriées, il est possible de surveiller le refroidissement et le débit d'air afin de remplir la spécification demandée.

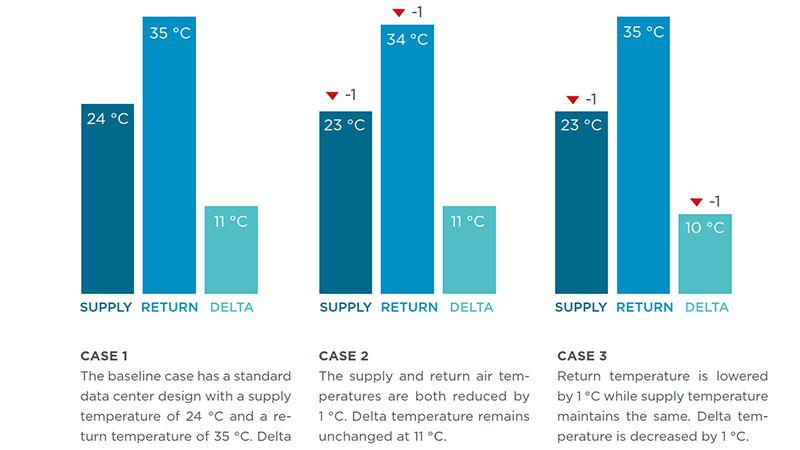

Pour évaluer les effets de différentes variables sur la consommation d'énergie annuelle moyenne, Munters a modélisé son système pour qu'il fonctionne à trois différents régimes de surveillance, dans trois endroits différents, chacun avec un centre de données soumis à une charge d'équipement informatique d'1 mégawatt :

- Le scénario de base présente une température d'alimentation de 24 °C et une température de retour de 35 °C (delta-T = 11 °C).

- Dans le second cas, les températures d'alimentation et de retour ont été abaissées de 1 °C (avec conservation de delta-T).

- Dans le troisième cas, seule la température de retour a été abaissée de 1 °C (avec une réduction de delta-T).

Les résultats ont montré une baisse de la consommation d'énergie dans les trois scénarios associés à un climat modéré. Le scénario #2 a montré une hausse de 1 à 2 pour cent de la consommation d'énergie obtenue en réduisant les températures d'alimentation et de retour d'un degré. Le scénario #3 a montré l'augmentation la plus significative de la consommation d'énergie ; en rabaissant la température d'1 °C seulement (et le delta-T), la consommation d'énergie a augmenté de 8 à 9 % dans les trois endroits. Cet effet significatif d'un petit écart de la température souligne l'importance de l'exactitude de l'écart delta-T et du capteur.

Quelles que soient les méthodes de refroidissement utilisées, il est extrêmement important de surveiller les processus CVC et les conditions intérieures de manière fiable. Pour ce faire, les gestionnaires de centres de données doivent pouvoir compter sur des mesures exactes et continues, la boucle de régulation dépendant étroitement des mesures. C'est pourquoi les capteurs de qualité assurent l'efficacité de la surveillance des processus CVC ainsi que la stabilité d'un environnement intérieur. Toutefois, la spécification du capteur au moment de l'installation n'indique pas nécessairement la fiabilité des performances sur le long terme. La valeur réelle d'un capteur est dérivée de son cycle de vie total, car les nécessités de maintenance fréquentes peuvent être onéreuses. Et comme le soulignent les modèles de Munters, les plus petits écarts de l'exactitude peuvent entraîner une hausse des frais d'énergie.

Dans la plupart des cas, les données de l'infrastructure informatique ont énormément de valeur et jouent souvent un rôle essentiel dans la réussite des opérations. Il n'y a donc une raison valable pour utiliser des capteurs bon marché si ceci entraîne des frais de maintenance élevés ou met en danger les données de grande valeur. Les utilisateurs devraient donc chercher des appareils de mesure durables, capables de fournir des résultats fiables et stables sur le long terme, car c'est cette fiabilité à vie qui fait la différence.

Technologie de mesure pour environnements exigeants

Depuis sa fondation qui remonte à plus de 86 ans, Vaisala se concentre sur la fabrication d'appareils de mesure exacts, fiables et stables. C'est pourquoi, ces caractéristiques sont les composantes fondamentales des exigences conceptionnelles de chaque produit Vaisala. Les capteurs Vaisala sont en service sur Mars depuis plus de huit ans où ils prouvent les avantages de ces caractéristiques en fournissant sans problème des données dans les conditions difficiles qui règnent à bord du Curiosity rover de la NASA et plus récemment du Perseverance rover.

Les centres de données représentent un environnement moins complexe que l'espace, mais la fiabilité des capteurs y joue un rôle équivalent étant donné leur importance pour le secteur commercial, économique et les sociétés du monde entier.

Les facteurs déterminants pour le choix des capteurs

1. Fiabilité

Il est évident que l'exactitude du capteur au point d'installation est importante, mais il est vital que le capteur reste exact sur le long terme et fournisse des résultats stables. Étant donné la valeur des centres de données, souvent situés loin des villes, la durée de vie des transmetteurs devrait être supérieure à la norme. Le fabricant devrait donc avoir une certaine expérience dans le secteur, associée à la réputation de fournir des mesures fiables dans les environnements critiques. Les certificats de l'étalonnage retraçable garantissent que les capteurs fonctionnaient correctement avant de sortir de l'usine. La fiabilité éprouvée signifie que ce niveau d'exactitude peut être maintenu sur le long terme.

2. Maintenance

Il est recommandé d'éviter les capteurs sujets à d'importants travaux de maintenance, pas seulement en raison des coûts impliqués, mais parce que ces capteurs augmentent le risque de panne. Par ailleurs, les capteurs sujets à la dérive ou à des pertes d'exactitude peuvent entraîner une augmentation énorme de la consommation d'énergie, comme sus-mentionné. Les hauts niveaux de disponibilité requis par les centres de données signifient que toute opération de maintenance des équipements de surveillance ne doit pas en perturber le fonctionnement. Par conséquent, les instruments comme ceux de Vaisala avec des sondes ou des modules de mesure interchangeables présentent de grands avantages, notamment parce qu'il est possible de retirer et d'étalonner les capteurs hors ligne. Il est important de noter que lors du remplacement d'une sonde ou d'un module de mesure, le certificat d'étalonnage doit également être mis à jour. Dans l’idéal, il devrait être possible d'effectuer les opérations de maintenance sur site avec les outils du fournisseur de l'instrument, dans le cadre d'un programme de maintenance programmé.

3. Durabilité

Du point de vue des capteurs, les technologies de la dernière génération permettent aux utilisateurs de mettre à niveau uniquement la partie d'un capteur dédiée au mesurage au lieu de remplacer et de jeter la totalité du transmetteur, ce qui permet d'éviter les déchets inutiles. Les références des fournisseurs en matière de protection de l'environnement et de durabilité devraient être consultées avant d'acheter un produit. Ceci permet d'intégrer le facteur durabilité aux chaînes d'approvisionnement et crée un moteur pour toutes les entreprises, grandes ou petites. La durabilité est au cœur de Munters et de Vaisala. Munters, par exemple, a installé des équipements de refroidissement d'une puissance totale supérieure à 1,5 gigawatt dans les centres de données du monde : des économies d'énergie équivalant à 2 % de la consommation annuelle de la Suède. Récemment, la société Vaisala a figuré dans le top 5 des European Climate Leaders 2022 du Financial Times. La liste répertorie les entreprises européennes ayant enregistré la plus grande réduction d'émissions de gaz à effet de serre entre 2015 et 2020.

Sommaire

Au regard des données critiques d'une valeur de plusieurs milliards de dollars traitées et stockées dans les centres de données, les serveurs énergivores doivent être maintenus dans des conditions de température et d'humidité idéales pour éviter les temps d'arrêt. Parallèlement, il existe des demandes urgentes en matière de réduction des émissions de gaz à effet de serre, d'optimisation de l'efficacité énergétique, de réduction des coûts énergétiques et d'amélioration du facteur PUE ; le tout à une époque où le coût de l'énergie monte en flèche. Cette « accumulation » de moteurs signifie que la surveillance exacte et l'optimisation des processus CVC sont extrêmement importantes.

À propos des auteurs

Keith Dunnavant est vice-président des ventes chez Munters et responsable des centres de données en Amérique du Nord et du Sud. Anu Kätkä est chef de produit chez Vaisala et responsable au niveau international des produits CVC et des centres de données de Vaisala.