Innovazione del data center: in che modo la precisione delle misurazioni consente l'efficienza energetica

Nell'articolo seguente, Keith Dunnavant di Munters e Anu Kätkä di Vaisala descrivono le tendenze recenti nel settore dei data center e discutono dell'impatto sull'efficienza energetica delle misurazioni negli impianti di riscaldamento, ventilazione e condizionamento dell'aria. Con l'aumento vertiginoso dei costi energetici e mentre i governi cercano urgentemente opportunità di riduzione delle emissioni di gas serra, l'efficienza energetica dei data center si è spostata al centro dell'attenzione internazionale.

Entrambi gli autori hanno una lunga esperienza e competenza nella gestione dell'energia nei data center. Munters è un leader globale nelle soluzioni di controllo del clima sostenibili ed efficienti dal punto di vista energetico per i processi mission-critical, inclusi i data center, mentre Vaisala è un leader globale nel settore delle misurazioni meteorologiche, ambientali e industriali.

Consumo energetico del data center

"Efficacia nell'uso dell'energia" (PUE) come unità di misura

La domanda globale di elettricità è di circa 20.000 terawattora; il settore ICT (Information and Communications Technology) utilizza 2.000 terawattora, mentre i data center circa 200 terawattora, pari all'1% del totale. I data center rappresentano quindi una parte significativa del consumo energetico della maggior parte dei paesi. È stato stimato che ci siano oltre 18 milioni di server nei data center a livello globale. Oltre ai propri requisiti di alimentazione, questi dispositivi IT richiedono anche infrastrutture di supporto come sistemi di raffreddamento, distribuzione dell'alimentazione, spegnimento di incendi, gruppi di continuità, generatori, ecc.

Per confrontare l'efficienza energetica nei data center, è prassi comune utilizzare come unità di misura l'efficacia nell'uso dell'energia (PUE). Questo è definito come il rapporto tra l'energia totale utilizzata in un data center e l'energia utilizzata solo dall'IT. In uno scenario ottimale, la PUE sarebbe 1, ossia tutta l'energia sarebbe consumata per l'IT e l'infrastruttura di supporto non consumerebbe energia.

Pertanto, per ridurre al minimo il valore di PUE, l'obiettivo è ridurre il consumo delle infrastrutture di supporto, come il raffreddamento e la distribuzione dell'alimentazione. Il valore PUE tipico nei data center tradizionali è di circa 2, mentre i grandi data center di hyperscale possono scendere al di sotto di 1,2. Nel 2020, la media globale era di circa 1,67, pertanto, in media, il 40% del consumo totale di energia è consumo non IT. Tuttavia, il valore di PUE è un rapporto, quindi non è indicativo del consumo energetico complessivo; pertanto, se i dispositivi IT consumano un livello elevato di energia rispetto al sistema di raffreddamento, il valore PUE avrà un buon valore. È quindi importante misurare anche il consumo energetico totale, nonché l'efficienza e il ciclo di vita delle apparecchiature IT. Inoltre, dal punto di vista ambientale, si dovrebbero prendere in considerazione il modo in cui viene prodotta l'elettricità, la quantità di acqua consumata (sia per generare l'elettricità sia nel sito per il raffreddamento) e l'eventuale utilizzo del calore di scarto.

Il concetto di PUE è stato originariamente sviluppato da Green Grid nel 2006 e pubblicato come standard ISO nel 2016. Green Grid è un consorzio industriale aperto di operatori di data center, fornitori di servizi cloud, fornitori di tecnologia e apparecchiature, architetti di strutture e utenti finali, lavorando a livello globale nell'efficienza energetica e delle risorse degli ecosistemi dei data center, cercando di ridurre al minimo le emissioni di carbonio.

Il valore di PUE rimane il metodo più comune per calcolare l'efficienza energetica dei data center. In Munters, ad esempio, la PUE viene valutata sia su base massima che su base annua per ciascun progetto. Quando si calcolano le metriche PUE, nel calcolo della PUE vengono presi in considerazione solo il carico IT e il carico di raffreddamento. Questo è indicato come PUE parziale (pPUE) o PUE meccanico (PUEM). Il picco pPUE viene utilizzato dagli ingegneri elettrici per stabilire i carichi massimi e per dimensionare i generatori di riserva. Il pPUE annualizzato viene utilizzato per valutare e confrontare con altre opzioni di raffreddamento la quantità di elettricità consumata durante un anno tipico. Anche se il valore di PUE può non essere uno strumento perfetto, è sempre più supportato da altre unità di misura come WUE (efficacia dell'utilizzo dell'acqua), CUE (efficacia dell'utilizzo del carbonio), nonché approcci che possono migliorare la rilevanza della PUE, tra cui SPUE (server PUE ) e TUE (PUE totale).

Tendenze del data center

Negli ultimi dieci anni i data center hyperscale efficienti hanno aumentato la loro quota relativa di consumo energetico totale dei data center, mentre molti dei data center tradizionali meno efficienti sono stati chiusi. Di conseguenza, il consumo totale energetico non è ancora aumentato drasticamente. Questi data center hyperscale di nuova costruzione sono stati progettati per l'efficienza. Tuttavia, sappiamo che ci sarà una crescente domanda di servizi di informazione e applicazioni ad uso intensivo di computer, a causa di molte tendenze emergenti come l'intelligenza artificiale, l'apprendimento automatico, l'automazione, i veicoli senza conducente e così via. Di conseguenza, si prevede che la domanda di energia dei data center aumenterà e il livello di aumento è oggetto di dibattito. Secondo lo scenario migliore, rispetto alla domanda attuale, il consumo energetico globale dei data center aumenterà di tre volte entro il 2030, ma si ritiene più probabile un aumento di otto volte. Queste proiezioni del consumo energetico includono sia l'infrastruttura IT che quella non IT. La maggior parte del consumo energetico non IT deriva dal raffreddamento o, più precisamente, dall'eliminazione del calore dai server e il solo costo del raffreddamento può facilmente rappresentare fino al 25% o più dei costi energetici totali annuali. Il raffreddamento è ovviamente una necessità per mantenere la funzionalità IT e può essere ottimizzato attraverso una buona progettazione e un funzionamento efficace dei sistemi dell'edificio.

Un'importante tendenza recente è l'aumento della densità di alimentazione dei rack dei server, con alcuni fino a 30-40 kilowatt e oltre. Secondo una ricerca condotta da AFCOM, l'associazione di settore per i professionisti dei data center, il rapporto 2020 State of the Data Center ha rilevato che la densità media dei rack è salita a 8,2 kW per rack, rispetto a 7,3 kW nel 2019 e 7,2 kW nel 2018. Circa il 68% degli intervistati ha riferito che la densità dei rack è aumentata negli ultimi tre anni.

Il passaggio al cloud computing sta sicuramente stimolando lo sviluppo di data center hyperscale e co-location. Storicamente, un data center da 1 megawatt sarebbe stato progettato per soddisfare le esigenze di una banca, di una compagnia aerea o di un'università, ma molte di queste istituzioni e aziende stanno ora passando a servizi cloud all'interno di strutture di data center hyperscaler e co-location. Come risultato di questa crescente domanda, vi è una maggiore richiesta di velocità dei dati e, naturalmente, tutti questi data center servono applicazioni mission-critical, quindi l'affidabilità dell'infrastruttura è molto importante.

Vi è anche una maggiore attenzione verso i data center edge per ridurre la latenza (ritardo), nonché verso l'adozione del raffreddamento a liquido per ospitare chip ad alte prestazioni e ridurre il consumo di energia.

Controllo di temperatura e umidità

Una delle considerazioni principali per l'efficienza energetica nel raffreddamento ad aria dei data center è il contenimento del corridoio di aria calda/fredda. Purtroppo, il contenimento è ancora mal gestito in molti data center pre-esistenti, portando a una bassa efficienza energetica. Le nuove costruzioni di data center, d'altra parte, tendono a prendere molto sul serio il contenimento, il che contribuisce in modo significativo alle prestazioni.

Per molti, le temperature dell'aria di mandata sono ottimali tra 24°C e 25,5° C. Tuttavia, delta-T è molto importante: la differenza di temperatura tra il corridoio caldo e il corridoio freddo. In genere, il valore delta-T è compreso tra 10 e 12°C, ma 14°C è un obiettivo comune nella progettazione del data center. L'aumento del valore delta-T comporta il duplice vantaggio di ridurre l'uso di energia del motore del ventilatore richiesto dai sistemi di raffreddamento e di aumentare il potenziale per economizzare le strategie di smaltimento del calore.

L'economizzazione è il processo mediante il quale l'aria esterna può essere utilizzata per facilitare una parte della dissipazione del calore del data center. Può avvenire direttamente, immettendo effettivamente l'aria esterna nei sistemi di raffreddamento e consegnata ai server (dopo un'adeguata filtrazione dell'aria), o indirettamente, espellendo l'aria di ricircolo del data center nell'ambiente tramite uno scambiatore di calore aria-aria. Così facendo si riducono i costi e si migliorano l'efficienza e la sostenibilità. Tuttavia, per mantenere l'efficienza, le perdite di pressione lato aria dovute alla filtrazione devono essere ridotte al minimo. Pertanto, se l'aria viene rimessa in circolo all'interno del data center senza l'introduzione di aria esterna, dovrebbe essere possibile ridurre o eliminare del tutto la necessità di filtrazione.

Il raffreddamento e la ventilazione richiedono un attento controllo ed è importante utilizzare ventilatori ad alta efficienza, mantenere una leggera pressione positiva dell'edificio e controllare l'umidità della stanza. I sistemi di aria di reintegro, ad esempio, dovrebbero controllare il punto di rugiada dell'ambiente sufficientemente basso in modo che le serpentine di raffreddamento effettuino solo un raffreddamento sensibile, senza dover affrontare un carico latente (rimozione dell'umidità dall'aria).

L'obiettivo generale del sistema di espulsione del calore è mantenere condizioni ottimali per le apparecchiature IT, riducendo al minimo il consumo di energia. Una bassa umidità, ad esempio, può aumentare il rischio di elettricità statica e un'umidità elevata può causare condensa, condizione che rappresenta una minaccia per le apparecchiature elettriche e metalliche, aumentando il rischio di guasti e riducendo la durata di vita. È stato dimostrato che elevati livelli di umidità combinati con vari inquinanti ambientali accelerano la corrosione di vari componenti all'interno dei server.

Il raffreddamento è fondamentale per eliminare il calore generato dalle apparecchiature informatiche ed evitare così il surriscaldamento e prevenire guasti. Secondo alcuni studi, una temperatura che fluttua rapidamente può effettivamente essere più dannosa per i dispositivi IT rispetto a una temperatura più elevata e stabile, quindi il circuito di controllo è importante da questo punto di vista.

Le apparecchiature IT più recenti sono in genere in grado di funzionare a temperature più elevate, pertanto la temperatura di aspirazione può essere aumentata, migliorando il potenziale di raffreddamento libero e di risparmio. L'aria esterna può essere utilizzata per raffreddare l'aria interna direttamente o indirettamente (come indicato sopra) e il raffreddamento evaporativo o adiabatico può migliorare ulteriormente l'efficienza dell'economizzazione. Queste tecnologie di risparmio energetico sono state ampiamente implementate, mentre l'attuale tendenza va verso strategie di rifiuto del calore secco che non consumano acqua. All'aumentare della temperatura del mezzo di estrazione del calore (aria o liquido), aumenta il potenziale di utilizzo efficace del calore di scarto dai data center, ad esempio nelle reti di teleriscaldamento. A Helsinki, ad esempio, Microsoft e il gruppo energetico Fortum stanno collaborando a un progetto per catturare il calore in eccesso. Il data center utilizzerà il 100% di elettricità priva di emissioni e Fortum trasferirà il calore pulito dal processo di raffreddamento del server alle abitazioni, ai servizi e ai locali commerciali collegati al suo sistema di teleriscaldamento. Questo impianto di riciclo del calore residuo del data center è probabilmente il più grande del suo genere al mondo.

L'importanza di un monitoraggio di precisione

In molte strutture moderne è previsto un tempo di attività del 99,999% a fronte di un tempo di inattività annuale solamente di pochi minuti l'anno. Tali livelli estremamente elevati di prestazioni sono necessari a causa dell'importanza e del valore dei dati e dei processi gestiti dall'infrastruttura IT.

Una caratteristica chiave nella progettazione dei data center è la fornitura della temperatura corretta ai server, e questo può essere ottenuto solo se il sistema di controllo è in grado di fare affidamento su sensori accurati. Sale dati più grandi possono essere più difficili da monitorare, perché hanno un maggiore potenziale di variabilità della temperatura spaziale, quindi è importante disporre di un numero sufficiente di sensori di temperatura per garantire che tutti i server siano monitorati.

Alcuni server potrebbero essere vicini a un'unità di raffreddamento, mentre altri potrebbero esserne più distanti; alcuni possono trovarsi nella parte inferiore di un rack e altri più in alto, quindi esiste il potenziale per la variabilità tridimensionale. Oltre a un numero sufficiente di sensori, è quindi importante anche che il flusso d'aria e il raffreddamento siano distribuiti in modo ottimale in tutta la sala server. Grazie a una combinazione di progettazione e monitoraggio adeguati, è possibile controllare in modo efficiente il raffreddamento e il flusso d'aria per soddisfare le specifiche richieste.

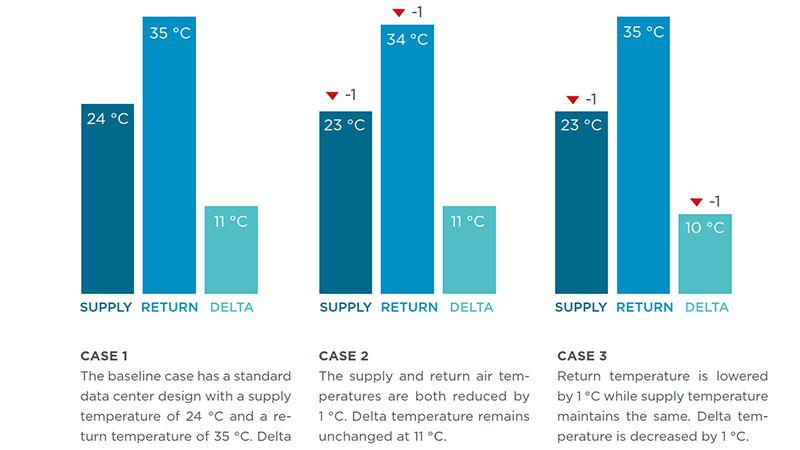

Per valutare gli effetti di diverse variabili sull'utilizzo medio annuo di energia, Munters ha modellato il proprio sistema operando con tre diversi regimi di controllo in tre diverse posizioni, ciascuno con un data center di carico ITE da 1 megawatt:

- Lo scenario base prevede una temperatura di mandata di progettazione di 24°C e una temperatura di ritorno di 35°C (deltaT = 11°C).

- Nel secondo caso, le temperature di mandata e ritorno sono state abbassate di 1°C (mantenimento del delta-T).

- Nel terzo caso, solo la temperatura di ritorno è stata abbassata di 1°C (delta-T ridotto).

I risultati hanno mostrato un consumo di energia inferiore in tutti e tre gli scenari nella posizione climatica più mite. Lo scenario n. 2 mostrava un consumo energetico aggiuntivo dell'1-2% abbassando le temperature di mandata e ritorno di un solo grado. Lo scenario n. 3 ha mostrato l'aumento più significativo del consumo di energia; abbassando la temperatura di ritorno di appena 1°C (e quindi il delta-T), il consumo di energia è aumentato dall'8 al 9% in tutte e tre le posizioni. Questo grande effetto dovuto a una piccola deviazione della temperatura evidenzia l'importanza sia del delta-T che della precisione del sensore.

Qualunque sia il metodo di raffreddamento utilizzato, è di fondamentale importanza controllare i processi di riscaldamento, ventilazione e condizionamento dell'aria e le condizioni interne in modo affidabile. Per raggiungere questo obiettivo, i responsabili dei data center devono poter contare su misurazioni continue e precise, poiché il circuito di controllo può essere valido solo quanto le misurazioni. Per questo motivo, i sensori di alta qualità consentono processi di riscaldamento, ventilazione e condizionamento dell'aria controllati in modo efficiente e un ambiente interno stabile. Tuttavia, le specifiche del sensore al momento dell'installazione non sono necessariamente un indicatore dell'affidabilità delle prestazioni a lungo termine. Il valore reale di un sensore viene ricavato durante il suo intero ciclo di vita, perché frequenti richieste di manutenzione possono essere costose e, come delineato nei modelli Munters, anche piccole deviazioni nella precisione possono portare a costi energetici esagerati.

Nella maggior parte dei casi, il valore dei dati nell'infrastruttura IT è estremamente elevato e spesso mission-critical, quindi non avrebbe senso implementare sensori a basso costo se ciò si traduce in costi di manutenzione elevati o rischi per i dati di alto valore. Gli utenti devono quindi cercare dispositivi di misurazione duraturi, in grado di fornire letture affidabili e stabili a lungo termine, perché è l'affidabilità di lunga durata ciò che conta davvero.

Tecnologia di misurazione per ambienti esigenti

L'attenzione verso la precisione, l'affidabilità e la stabilità dei dispositivi di misurazione è un valore chiave del marchio per Vaisala sin dalla sua fondazione, avvenuta oltre 86 anni fa. Queste caratteristiche sono quindi componenti fondamentali del mandato progettuale per ogni prodotto Vaisala. A dimostrazione dei vantaggi di queste caratteristiche, i sensori Vaisala operano sul pianeta Marte da oltre otto anni, fornendo dati senza problemi in condizioni difficili a bordo del Curiosity rover della NASA e, più recentemente, sul Perseverance rover.

I data center rappresentano un ambiente meno impegnativo rispetto allo spazio, ma i sensori affidabili sono ugualmente importanti dato il servizio essenziale che i data center forniscono alle imprese, alle economie e alle società di tutto il mondo.

Fattori che influenzano la scelta dei sensori

1. Affidabilità

La precisione del sensore nel punto di installazione è ovviamente importante, ma è fondamentale che il sensore rimanga preciso nel lungo termine fornendo letture stabili. Dato l'elevato valore dei data center e spesso la loro ubicazione remota, la durata dei trasmettitori deve essere ben al di sopra della norma. Il produttore deve quindi avere esperienza nel settore, unita a una reputazione nell'ambito delle misurazioni affidabili in ambienti critici. I certificati di calibrazione tracciabili garantiscono che i sensori funzionino correttamente prima di lasciare la fabbrica e una comprovata affidabilità significa che questo livello di precisione può essere mantenuto a lungo termine.

2. Manutenzione

I sensori con un elevato fabbisogno di manutenzione devono essere evitati, non solo perché implicano costi elevati, ma anche perché sono soggetti a maggiori rischi di guasto. Inoltre, i sensori che si spostano o perdono precisione possono comportare enormi costi energetici, come spiegato sopra. Gli elevati livelli di operatività richiesti dai data center significano che eventuali operazioni di manutenzione per le apparecchiature di monitoraggio non devono disturbare il funzionamento del data center. Di conseguenza, strumenti come quelli di Vaisala, dotati di sonde o moduli di misurazione intercambiabili sono vantaggiosi, anche perché consentono di rimuovere e calibrare i sensori offline. È importante sottolineare che, in caso di sostituzione di una sonda o di un modulo di misurazione, è necessario aggiornare anche il certificato di calibrazione. Idealmente, dovrebbe essere possibile eseguire operazioni di manutenzione in loco con i dispositivi del fornitore dello strumento, e questo lavoro dovrebbe essere svolto come parte di un programma di manutenzione programmata.

3. Sostenibilità

Per quanto riguarda il sensore, le ultime tecnologie consentono agli utenti di aggiornare solo la parte di misurazione di un sensore anziché cambiare o rottamare l'intero trasmettitore, contribuendo così ad evitare inutili sprechi. Le credenziali ambientali e di sostenibilità dei fornitori dovrebbero essere considerate quando si prendono decisioni di acquisto. Ciò consente di trasmettere la sostenibilità a cascata lungo le catene di approvvigionamento e crea un fattore di impulso per tutte le imprese, grandi o piccole. La sostenibilità è prioritaria sia per Munters che per Vaisala. Munters, ad esempio, dispone di oltre 1,5 gigawatt di apparecchiature di raffreddamento per data center installate a livello globale: un risparmio energetico pari al 2% del consumo energetico annuo della Svezia. Vaisala è stata recentemente inserita tra le migliori 5 aziende leader europee per il clima 2022 del Financial Times. L'elenco comprende le aziende europee che hanno ottenuto la maggiore riduzione delle proprie emissioni di gas serra tra il 2015 e il 2020.

Riepilogo

Con dati critici del valore di miliardi di dollari elaborati e archiviati nei data center, i server a elevato consumo energetico devono essere mantenuti in condizioni di temperatura e umidità ideali per evitare tempi di inattività. Allo stesso tempo, vi è un'urgente necessità di ridurre le emissioni di gas a effetto serra e i costi energetici, nonché di migliorare l'efficienza energetica e le misurazioni del valore di PUE, il tutto in un momento di costi energetici vertiginosi. Questa "tempesta perfetta" di fattori implica che il controllo e l'ottimizzazione precisi dei processi di riscaldamento, ventilazione e condizionamento dell'aria sono estremamente importanti.

Informazioni sugli autori

Keith Dunnavant è vicepresidente del reparto vendite di Munters, nonché responsabile del business aziendale nel settore dei data center nelle Americhe. Anu Kätkä è Product Manager di Vaisala e responsabile dell'area HVAC globale e data center di Vaisala.